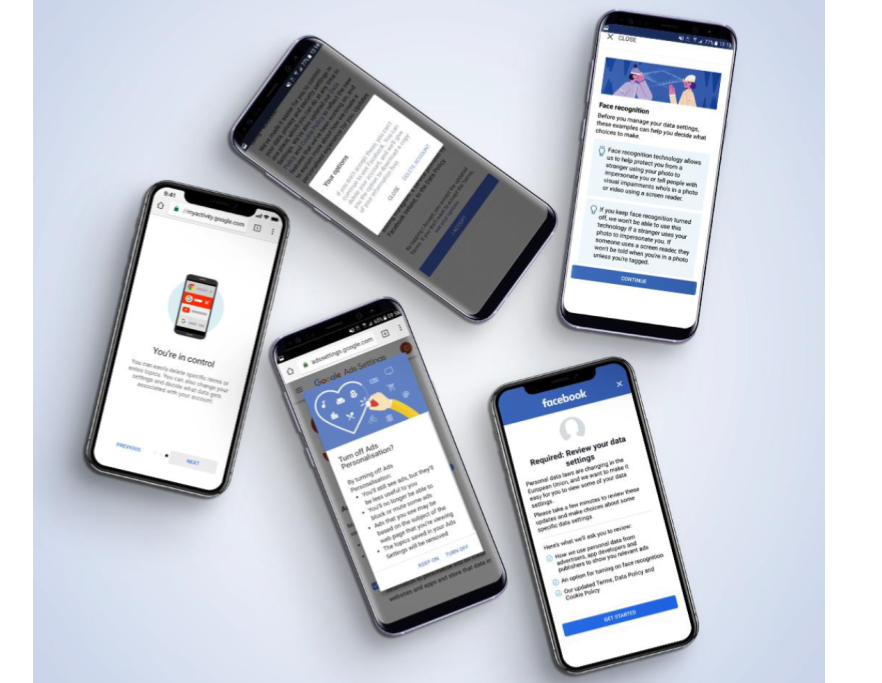

El Consejo de Consumidores de Noruega y el grupo paneuropeo BEUC alertan de las técnicas que Facebook, Google, Microsoft, Amazon… utilizan para evitar la normativa europea.

Los proveedores de servicios digitales utilizan una amplia gama de técnicas de diseño para incentivar a los usuarios a hacer clic y favorecer ciertas opciones. La creación de experiencias de navegación agradables es fundamental para un buen diseño centrado en el usuario. Pero estas técnicas se pervierten cuando se usan en detrimento de los usuarios y en beneficio del proveedor de servicios.

Así ocurre con determinadas pràcticas de grandes proveedores digitales que burlan la confianza de sus usuarios y vulneran la protección de sus datos y su privacidad, según concluye un estudio realizado por el Consejo de Consumidores de Noruega en el que se analizan trucos de diseño, los denominados “patrones oscuros”, utilizados por Google, Facebook y Microsoft para sortear la normativa europea sobre protección de datos.

Por su parte, el grupo paneuropeo de consumidores BEUC acaba de denunciar que las 14 mayores empresas de Internet utilizan, como mínimo, un lenguaje impreciso en sus informaciones sobre protección de datos.

Los grandes proveedores digitales vulneran la confianza de sus usuarios

El estudio de los consumidores noruegos, realizado durante las semanas siguientes a la entrada en vigor de la RGPD, considera que los proveedores de servicios digitales vulneran la confianza que sus usuarios depositan en ellos sobre qué datos compartir y cómo deben ser usados.

“La confianza es la base de cualquier buena relación con el cliente. El engaño y la manipulación conducen a la erosión de la confianza. Cuando los servicios digitales emplean patrones oscuros para impulsar a los usuarios a compartir más datos personales de los necesarios es el incentivo financiero el que prevalece sobre el respeto al derecho de los usuarios. Las prácticas que se usan para engañar a los consumidores a que hagan ciertas elecciones que pueden poner en riesgo su privacidad son poco éticas y explotadoras”, dice el estudio.

Las big tech analizadas acostumbran a presentar valores, diseños, símbolos y textos predeterminados que favorecen sus intereses. Los usuarios que desean un mayor control de su privacidad tienen que pasar por un proceso de navegación significativamente más largo e incluso descubrir por su cuenta opciones deliberadamente oscurecidas para que el usuario desista de las opciones no predeterminadas, bajo la amenaza de pérdida de funcionalidades o eliminación de su cuenta si no las elige.

Los usuarios tienen un control de sus datos más limitado de lo que parece

Según el estudio, Facebook le da al usuario una sensación de control sobre la cesión de datos a terceros para mostrar anuncios, pero resulta que el control es mucho más limitado de lo que parece inicialmente. Por su parte, el panel de privacidad de Google promete dejar que el usuario elimine fácilmente sus datos, pero el tablero de instrumentos resulta de difícil navegación, más parecido a un laberinto que a una herramienta de control.

El estudio analiza diversas categorías de trucos o “patrones oscuros” utilizados: las configuraciones predeterminadas, la facilidad de uso, los elementos destacados, las recompensas y castigos, las acciones forzadas y la ilusión de control.

Ninguna de estas categorías es intrínsecamente poco ética dado que todas ellas pueden ser utilizadas para lograr resultados que estén en sintonía con lo que desean los usuarios, pero cuando se utilizan en favor de los intereses del proveedor se convierten en prácticas que vulneran el principio de libertad en el que se basa el consentimiento explícito exigido por la RGPD.

Configuraciones predeterminadas

Las investigaciones sobre el comportamiento de los usuarios demuestran que la mayoría nunca comprueba, y mucho menos cambia, la configuración predeterminada que le presenta el proveedor. Por esta razón, la configuración predeterminada debe ser elegida con cuidado y responsabilidad.

La normativa europea dice que la configuración predeterminada no debe permitir una mayor recopilación de datos de la que se requiere para proporcionar el servicio, y que el uso de datos personales para otros fines requiere una autorización explícita.

Sin embargo, tanto Facebook como Google eluden este principio.

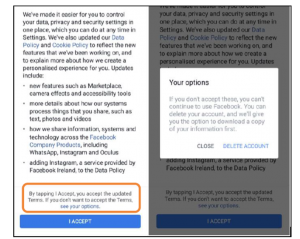

El estudio presenta diversas pràcticas impropias, como la ventana emergente sobre cumplimiento de la RGPD de Facebook. En ella se requiere que los usuarios accedan a “Administrar configuración de datos” para desactivar anuncios. Si el usuario simplemente hace clic en “Aceptar y continuar“, la configuración se activa automáticamente. Esto no es privacidad por defecto.

Del mismo modo, la configuración de Google para la personalización de anuncios requiere que el usuario acceda al panel de privacidad para deshabilitarlos. La personalización viene por defecto.

El estudio añade diversos ejemplos de lo que denomina “incumplimientos ocultos” en relación a la personalización de anuncios y accesos de terceros a datos.

Facilidad de uso

Si lo que se pretende es conducir a los usuarios en una dirección determinada, hacer que el proceso hacia otras alternativas sea un proceso largo y arduo es un “patrón oscuro”, tanto en la configuración predeterminada, como mediante determinados diseños, el uso de ciertos colores o el destacado de botones u opciones.

Ejemplo: En la ventana emergente sobre RGPD de Facebook, un botón azul brillante invita a los usuarios a “Aceptar y continuar“. Al hacer clic en el botón, el usuario accede a una nueva pantalla sobre reconocimiento facial, con otro botón similar para aceptar y continuar.

Los usuarios que quieran limitar los datos que Facebook recopila, primero tienen que hacer clic en un cuadro gris con la etiqueta “Administrar configuración de datos” y se les guía a través de una larga serie de clics que finalmente conducen a desactivar “Anuncios basado en datos de socios y el uso de tecnologías de reconocimiento facial”. El camino es considerablemente más largo.

La opción que el proveedor quiere que sus usuarios elijan se hace deliberadamente más llamativa. Además, el usuario no sabe qué le espera detrás de “administrar el botón de configuración de datos”. Se puede encontrar dificultades difíciles de manejar. Lo más fácil siempre es aceptar y continuar lo que propone el proveedor.

En positivo o en negativo

Para incentivar a los usuarios a tomar ciertas decisiones, la forma en que se presentan diferentes opciones es un factor de motivación efectivo. Al destacar los aspectos positivos de una opción, mientras se pasa por alto cualquier posible efecto negativo, se consigue que muchos usuarios se inclinen por cumplir los deseos del proveedor del servicio.

Así ocurre, por ejemplo, en el acceso a la tecnología de reconocimiento facial de Facebook. El reconocimiento facial implica el procesamiento de datos biométricos, considerados sensibles en virtud de la RGPD, lo cual requiere disponer de un documento separado y explícito de consentimiento.

Al hacer clic en la ventana de RGPD de Facebook, se pregunta a los usuarios si aceptan el uso de tecnologías de reconocimiento facial. La tecnología es, según el menú emergente, utilizada para fines “Como ayudarlo a protegerse de extraños usando su foto” y “advertir a las personas con impedimentos visuales que su rostro está en una foto o un video“. La siguiente pantalla informa al usuario que “si mantiene el reconocimiento facial desactivado, no podrá usar esta tecnología si un extraño usa su foto para hacerse pasar por usted.” Este planteamiento mueve a los usuarios hacia una elección determinada y presenta la alternativa contraria como éticamente cuestionable o arriesgada.

Premio y castigo

Con el fin de atraer a los usuarios a tomar ciertas decisiones, una estrategia común consiste en utilizar incentivos para recompensar la elección “correcta” y castigar las elecciones que el proveedor de servicios considera indeseables.

La recompensa puede consistir en facilitar una funcionalidad adicional o un mejor servicio, mientras que el castigo podría ser el opuesto. Esto es particularmente problemático si la recompensa y el castigo no están directamente relacionados con la elección que se está presentando.

En la última página del popup de RGPD de Facebook, a los usuarios se les presenta una elección aparente con respecto a los nuevos términos de usuario. Escondido sobre el gran botón azul de “aceptar”, el texto advierte que se puede optar por otro botón que consiste en “ver sus opciones “. Al hacer clic ahí se conmina al usuario a regresar y aceptar los términos, o dejar de navegar y eliminar su cuenta. Dado que los usuarios potencialmente tienen años de información valiosa almacenados en sus perfiles, junto con su red de amigos, esto no parece una buena elección. La amenaza de eliminación es un castigo suficiente para disuadir a la mayoría de los usuarios. Tómalo o déjalo.

Acciones forzadas

A menudo, los consumidores usan servicios digitales en sus teléfonos mientras viajan o en situaciones que requieren inmediatez.

Obligar a los usuarios a elegir en el acto supone un fuerte incentivo para impulsar las decisiones que interesan al proveedor.

Cuando los usuarios reciben por primera vez la ventana emergente de RGPD en Facebook, tienen dos opciones. O bien hacer clic en “Comenzar“, o hacer clic en la X en la esquina para cerrar la ventana emergente. Al hacer esto último, aparece otra ventana que advierte: “Usted necesita terminar la revisión de estas configuraciones para continuar usando Facebook “. Esto da la impresión de que el usuario no podrá usar Facebook hasta que la configuración haya sido revisada, lo cual resulta ser falso. Los usuarios pueden efectivamente posponer su elección. Pero se supone que el usuario, al abrir su aplicación, está interesado en acceder a Facebook inmediatamente. Por lo tanto, la única opción que en esos momentos parece posible es hacer clic en “comenzar“.

Ilusión de control

A través de sus ventanas emergentes sobre privacidad, tanto Facebook como Google enfatizan que están dando a los usuarios el control de sus datos.

Los estudios de comportamiento indican que los usuarios que creen tener más control se sienten más seguros y dispuestos a asumir más riesgos cuando divulgan información. Se trata de una paradoja que hace particularmente importante que los controles sean realmente efectivos. Si a los usuarios solo se les da la ilusión del control, pero se les burla el control real, se les está manipulando para que no sean tan estrictos con la protección de sus datos