La perspectiva tecnológica asume que la intimidad emocional puede reducirse a datos

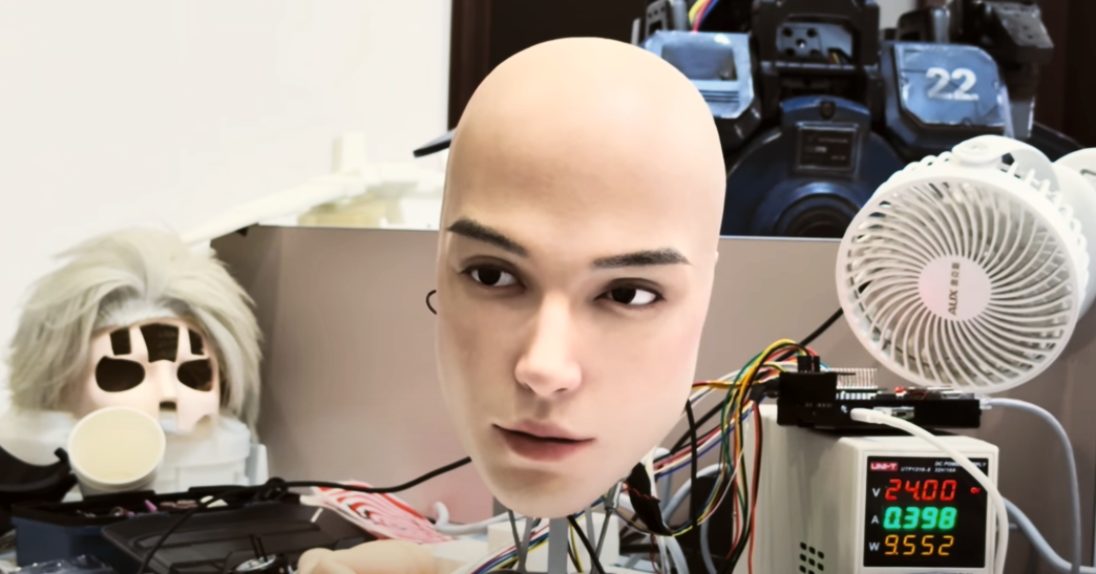

El desarrollo de la inteligencia artificial se empeña en dotar de empatía emocional a los chatbots y artefactos de ese estilo. Replicarnos se ha convertido en el gran objetivo científico de la humanidad y, en consecuencia, se considera que cuanto más humanizados estén los asistentes digitales, mejor.

A eso se orientan las aplicaciones de generación de voz e imagen hiperrealistas que tratan de emular hasta el mínimo detalle la expresividad humana.

La obsesión por la emulación parte del propio concepto fundacional de la IA según el cual, la inteligencia humana no es más que un sistema de procesos biofísicos y bioquímicos identificables, convertibles en datos y, por lo tanto, replicables. También las emociones y los sentimientos.

Desde la perspectiva tecnológica se asume que el rostro es el «espejo del alma» y que la intimidad emocional puede inferirse a partir de la interpretación de las expresiones.

Europa pone barreras

De ahí, las inversiones crecientes en sistemas que tratan de adivinar lo que sentimos. Microsoft ha patentado sistemas de análisis de expresiones faciales y lenguaje corporal en reuniones de trabajo. Google desarrolla modelos que reconocen estados afectivos. Amazon incorpora detección emocional en sus asistentes de voz.

En Europa se han puesto barreras al uso indiscriminado de estos sistemas de vigilancia, especialmente en el trabajo y la educación, porque invaden la privacidad y porque, entre otros efectos, reducir a datos el complejo universo íntimo de las personas favorece las interpretaciones sesgadas o erróneas. Se ha comprobado, por ejemplo, que los modelos de emulación tienden a sobre identificar emociones negativas en la expresión de las personas racializadas.

Aún así, la tentación de reducir las emociones a modelos y patrones automatizables es superior a las barreras que tratan de poner ciertos límites. Omiten gran parte de la riqueza de la vida emocional y del comportamiento humano pero su simplicidad promete negocio.

Amigos para siempre

Una vez se asume que la complejidad humana se puede reducir a datos, todo es susceptible de analizar y de reproducir.

Los amigos, los compañeros, los terapeutas, los asistentes pueden ser recreados, aparentemente con tanta empatía como la que tenemos entre nosotros.

Mark Zuckerberg dice estar convencido de que la IA puede resolver la creciente soledad de las personas: no puede simular el contacto físico pero sí el emocional.

Yair Rosenberg reseña en The Atlantic que, este verano, una empresa llevó la visión de Zuckerberg a la práctica y comenzó a distribuir un dispositivo llamado «Friend«. Se trata de un colgante con inteligencia artificial que escucha a su portador y puede entablar una conversación con él. Un tráiler muestra a los usuarios hablando en voz alta con su confidente incorpóreo mientras come, pasea o juega, como si fuera tan real como un humano.

Delirios inducidos

También recientes, dos artículos cuentan las historias de dos personas que experimentaron delirios inducidos por su relación con chatbots. Allan Brooks pasó tres semanas convencido de haber descubierto una nueva rama de las matemáticas. En marzo, Thongbue Wongbandue salió de su casa en Nueva Jersey para encontrarse con una mujer que no existía. Ambos habían interactuado con chatbots que simulaban una comprensión emocional tan convincente que alteraron su conexión con la realidad.

El rápido avance de los sistemas de «empatía automatizada» ha alertado del peligro que corre la integridad mental que protege la autonomía, estabilidad emocional y libertad cognitiva de las personas.

Visión del todo

Andrew McStay advierte en Automating Empathy que las emociones humanas tienen cualidades experienciales, intencionales, comunicativas, históricas, culturales y sociales que no pueden capturarse mediante algoritmos.

El ser humano es complejo y asumir que la intimidad personal puede ser medida, clasificada y replicada por simulaciones digitales nos devalúa. La datificación de la intimidad nos pone en riesgo.

Recuerda McStay que un principio central de la filosofía japonesa de la Escuela de Kioto exige tener una visión moral holística de los efectos de la tecnología. La vida humana, con sus emociones, debe ser analizada como un todo. Su disociación y reducción a datos nos lleva a ver a los demás y a nuestro entorno como meros objetos aislables y disponibles y, por tanto, susceptibles de explotación.

Joan Rosés