El profesor del MIT analiza cuatro barreras que deberían superarse para que el desarrollo de la inteligencia artificial se alinee con las necesidades del ser humano

«La IA conduce a un exceso de automatización y eso es algo muy grave»

«Manipulación: el problema con las redes sociales es la punta del iceberg de lo que viene con la IA”

Conviven dos visiones diferentes de la IA. La que pretende construir máquinas que sean superiores a los humanos siguiendo la estela de los experimentos de Alan Turing y la que ciñe sus objetivos a que las máquinas sean útiles a los humanos siguiendo la corriente iniciada por Norbert Wiener.

La primera, la más ambiciosa, que aplican con entusiasmo empresas como OpenAI, parece imponerse ante la más cautelosa y, visto lo visto, la más sensata.

Daron Acemoglu, uno de los economistas norteamericanos actuales de más prestigio, ha dedicado parte de sus últimos trabajos a analizar los motivos que impiden el desarrollo de la orientación más juiciosa. Su libro «Poder y progreso» aborda el tema.

Hace unas semanas expuso sus reflexiones en un seminario organizado por la Digital Humanisme Initiative (DigHum), con sede en Viena. En su ponencia, titulada “¿Podemos tener una IA pro humana?”, desgranó los cuatro principales obstáculos que a su juicio impiden alinear el interés de los impulsores de la inteligencia artificial con las necesidades reales del ser humano.

Según Acemoglu, los cuatro obstáculos son:

– Exceso de automatización (la IA está contribuyendo a ello).

– Reducción de la diversidad y de las alternativas que alimentan el conocimiento.

– Desacoplamiento entre la cognición humana y los algoritmos.

– Monopolización del control de la información.

A continuación, resumimos parte de su ponencia que se puede seguir completa aquí.

Exceso de automatización

(15.06) “Creo que la automatización excesiva es algo muy grave. La orientación actual de la inteligencia artificial abre un camino casi directo hacia la automatización. Si tratamos de alcanzar la inteligencia suficiente para que una máquina sea autónoma es porque pretendemos que las máquinas ejecuten tareas que ahora realizan los humanos. De hecho, algunas personas están muy motivadas con esa perspectiva. No sólo sueñan con la inteligencia artificial general sino que consideran un éxito alcanzar la paridad entre la máquina y lo humano. Eso crea una vía natural hacia la automatización. Como consecuencia no se estará logrando la compatibilidad deseada y la promesa de crear máquinas que estén al servicio de los seres humanos se desvanecerá.”

Según Acemoglu, la automatización tiene más efectos contraproducentes de los que se suele reconocer. Señala que la caída de los salarios reales ocurrida en Estados Unidos desde 1980 en muchos grupos de ocupación se debe en buena parte al efecto de la automatización. Tampoco hay evidencias históricas de que la productividad, el empleo y el bienestar social mejoren como consecuencia de la automatización.

(21.25) Esto se ve, por ejemplo, en la revolución industrial. Los primeros 100 años fueron verdaderamente terribles para los salarios, el bienestar y la salud de los trabajadores. La segunda fase fue mejor, pero no se debió a una corrección automática. Fue el resultado de reformas políticas fundamentales. Se transformó la organización laboral y se inició una conceptualización de la tecnología completamente diferente. Con la IA generativa no sabemos qué ocurrirá, es una tecnología demasiado reciente, pero algunos estudios previos sobre la IA han demostrado que su único objetivo es la automatización”.

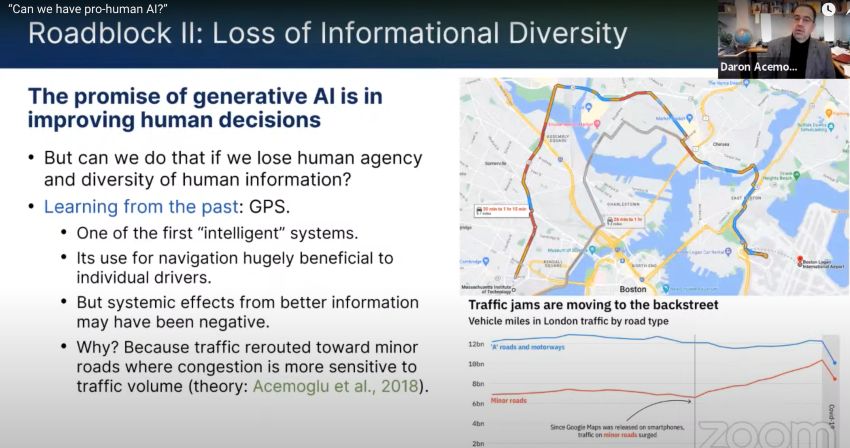

Eliminación de la duda y la diversidad

Uno de los riesgos de cualquier tecnología que procesa o proporciona información es la tendencia a eliminar la diversidad. La máquina está programada para elegir siempre la opción que, según sus cálculos, considera más adecuada. Nos ahorra el proceso de experimentar con la duda, con otras alternativas o incluso con los errores. Pero en muchas ocasiones conocer y experimentar la diversidad de opciones es una parte esencial del proceso de formación y desarrollo del conocimiento humano. “Con la IA se corre el riesgo de corregir demasiado, eliminar la diversidad y provocar una degradación del conocimiento.”

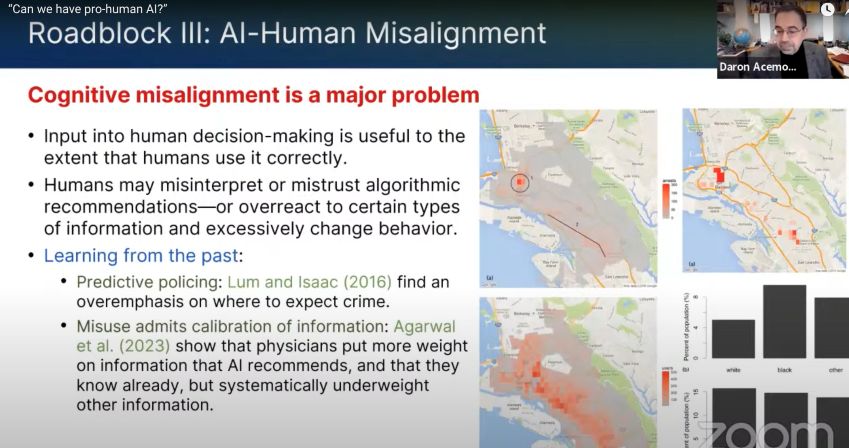

Desalineación con lo humano

(29.53) “Si una máquina te da un consejo puedes hacer tres cosas. Ignorarlo por completo, en cuyo caso no es útil. Seguirlo incondicionalmente, lo cual es horrible, nunca deberíamos hacerlo. O intentar comprender qué pretende la máquina, qué información está manejando y qué perspectiva adicional se puede aportar al problema. Pero eso, actualmente, es imposible porque los modelos de IA son en gran medida cajas negras y no es posible que las personas entiendan el motivo de una recomendación.”

En varios ámbitos, como el policial o el sanitario, se han producido errores graves debidos a esa incomprensión. Pero, aunque no se produzcan errores de bulto, se ha comprobado que la IA generativa apenas aporta mejoras sustanciales por la desconfianza que provoca.

(31.05) “En el caso de los médicos esa desconfianza se debe a que no entienden el por qué de una recomendación. Piensan que el conocimiento específico que ellos tienen del paciente no la tiene la IA. Así que no le dan demasiada importancia a la recomendación automatizada e ignoran información que sí podría serles útil. Eso es lo que quiero decir con desalineación de la IA. El riesgo de que los humanos no entiendan lo que hay en la máquina y las máquinas no interactúen adecuadamente con los humanos, al menos con la arquitectura actual de la IA generativa.

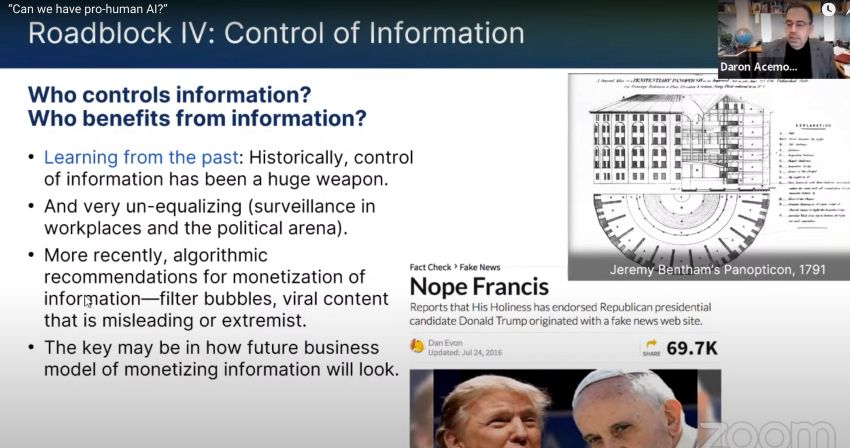

Monopolio de la información y colapso de la democracia

El cuarto obstáculo que impide alinear la IA con las necesidades humanas radica en la monopolización del control de la información, cada vez mayor.

(32.52) “El monopolio del control de la información tendrá implicaciones sobre cómo se organiza el trabajo y sobre cómo se organiza la política. Creo que los problemas de las redes sociales en términos de desinformación o manipulación pueden ser la punta del iceberg porque con la IA generativa existirá la posibilidad de difundir mensajes manipuladores individualizados. (…) Esto realmente afecta al núcleo mismo de la democracia tal como Hannah Arendt previó hace unas décadas: si todo el mundo te miente, la consecuencia no es que te creas las mentiras, sino que ya nadie se cree nada. Eso significa que el entendimiento compartido, que es la base de la democracia, puede colapsar.”

Qué hacer

Para hacer frente a esos cuatro desafíos, Acemoglu considera que la reacción difícilmente vendrá de la propia investigación tecnológica, hoy completamente dominada por la industria.

“Si creemos necesario reorientar la dirección que está tomando la IA generativa para que esté en línea con la promesa de la complementariedad humana, hay muchas palancas políticas potenciales que se pueden activar. No hay una solución milagrosa, pero sí diversas. Hay que alejarse del fomento de la automatización, introducir nuevas figuras fiscales en la política tributaria, revisar la propiedad de los datos, establecer impuestos a la publicidad digital, revisar ciertos tipos de subsidios y, en general, aplicar nuevas regulaciones.”

Añade, sin embargo, que si eso no basta probablemente habrá que ser más radical y replantear la arquitectura de la IA generativa para impedir la desalineación con lo humano.

1 comments

Lo que preveia Hannah Arendt referente a la mentira y la democracia lo podemos constatar ya, hoy dia con una intensidad creciente y con resultados que estan a la vista.

Si las consecuencias negativas, al inicio (100 años) de la revolución industrial para la clase obrera, solo se corrigieron con profundas reformas políticas, parece evidente que no se tendría que esperar 100 años a que las profundas trasnformaciones políticas ocurrieran.