Se disparan las alarmas ante la implantación acelerada de técnicas de reconocimiento facial.

El reconocimiento de imágenes es uno de los desarrollos tecnológicos estrella de los últimos años. Sus aplicaciones son vistosas aunque a veces no exentas de polémica como el VAR en el fútbol. Los deportes son un campo abonado a aplicaciones de este tipo. Hace más de diez años comenzó a implantarse el “ojo de halcón” en los partidos de tenis y en otros ámbitos, hace aún más tiempo, se generalizó la lectura de matrículas para acceder a los aparcamientos.

La fase más reciente y controvertida del reconocimiento de imágenes es el que afecta a los rostros e identidad de las personas. La tecnología se popularizó en 2017 cuando, en una accidentada presentación, Apple hizo pública la aplicación Face ID en los Iphones X. Impresionante. Con una sonrisa podías desbloquear el teléfono.

Sin embargo, el campo donde se ha expandido el reconocimiento facial no es en el de las sonrisas, sino en el de la vigilancia. China lidera el desarrollo e implantación de control ciudadano, Rusia fue una de las pioneras con la tecnología Find Face, y multinacionales norteamericanas como Amazon, con Rekognition, Microsoft o IBM se apresuran a no perder terreno.

En tiempos de recorte de presupuestos y de sensación generalizada de inseguridad, la aparición de aplicaciones que permiten identificar sospechosos mediante cámaras de vigilancia en las calles o mediante la monitorización de imágenes obtenidas en Internet ha sido una bendición para los cuerpos de seguridad de todo el mundo.

Tres bendiciones para las policías

Más que una bendición, han sido tres: automatizan la vigilancia, aumentan la escala y permiten hacer predicciones. Lo destaca un informe reciente del Ainow Institute de la Universidad de Nueva York.

Con los sistemas de inteligencia artificial se puede automatizar la vigilancia y aumentar la eficiencia, mucho más allá de las capacidades limitadas del ser humano y del análisis y codificación manuales. Un reducido número de agentes puede centralizar todas las funciones que hasta ahora necesitaban ingentes recursos.

Estos sistemas pueden también escalar exponencialmente el ámbito de análisis y seguimiento a través de grandes cantidades de datos, estableciendo conexiones e inferencias que habrían resultado imposibles antes de su introducción. Por último, proporcionan nuevas capacidades predictivas para hacer conjeturas acerca del carácter y comportamiento de las personas y definir el riesgo de determinados perfiles, lo cual aumenta la posibilidad de control ‘granular’ de la población,

Vuelve el interés por la fisonomía

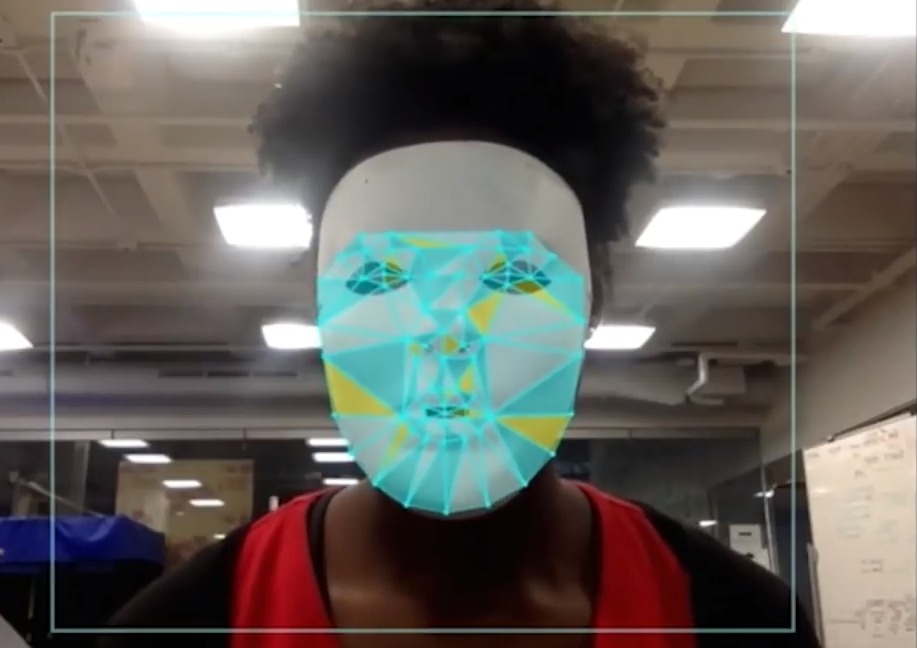

Las posibilidades del reconocimiento facial aumentan exponencialmente en combinación con otras tecnologías basadas en inteligencia artificial.

Se están implantando a gran escala aplicaciones que analizan vídeo, audio, imágenes y contenidos de medios sociales que identifican a individuos y/o grupos y se combinan con otras herramientas más sofisticadas como la lectura automatizada de labios y así observar e interpretar el habla a distancia.

Una vez identificado, un rostro puede vincularse con otros registros personales o datos identificables de comportamiento, la puntuación de crédito social (como en China) o antecedentes penales.

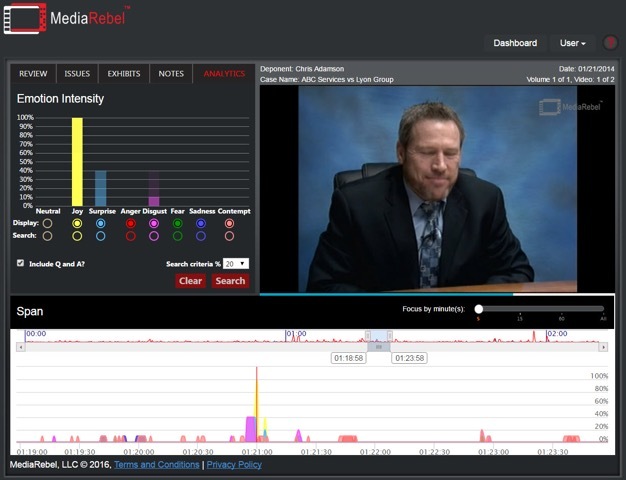

La sofisticación se completa mediante la combinación con herramientas de análisis de sentimiento y emociones. Se trata de algoritmos que, supuestamente, detectan automáticamente los estados emocionales internos o incluso las intenciones ocultas a partir del reconocimiento facial.

Se reactiva así la tradición de la fisonomía, una pseudociencia según la cual los rasgos faciales pueden revelar aspectos innatos de nuestro carácter o nuestra personalidad. El interés por la fisonomía creció en el siglo XIX pero cayó en desgracia tras su vinculación con procedimientos de segregación implantados por la Alemania nazi.

Preocupa que los sistemas de IA puedan ser capaces de decirnos lo que un estudiante, un cliente o un sospechoso sienten realmente o que se utilicen para la selección de personal en las empresas.

Predecir las emociones

Las aplicaciones no sólo se expanden en el terreno de la seguridad y la vigilancia. La educación es también un campo de pruebas. Algunas universidades de Estados Unidos han anunciado planes para utilizar software de análisis de estudiantes. La Universidad de St. Thomas, en Minnesota, está usando un sistema basado en el reconocimiento facial de Microsoft para observar a los estudiantes en el aula mediante una cámara web. El sistema “predice” el estado emocional de los alumnos.

Affectiva, empresa norteamericana especializada en medición de las emociones, asegura que es capaz de facilitar una conducción más segura mediante “el control de las emociones, los estados cognitivos, y las reacciones del rostro y la voz del conductor y los ocupantes”.

Se disparan las alertas

Ante la proliferación de soluciones, se han disparado las alertas. El informe del Ainow Institute, publicado en diciembre, lo firmó un remarcable número de investigadores. Hace también unas semanas se ha puesto en marcha el compromiso Safe Face Edge, un código ético al que pueden adherirse las empresas, impulsado por investigadores del MIT, la Liga por un Algoritmo Justo y el Centro sobre Privacidad y Tecnología de la Universidad de Georgetown. En Inglaterra, Big Brother Watch denuncia campañas de vigilancia de la policía británica desde 2009. Tambièn en la prensa internacional proliferan los reportajes y artículos de opinión que advierten del peligro de los excesos de esta tecnología.

Demasiados errores

El primer motivo de alarma son los errores que cometen los sistemas de reconocimiento facial. La revista The New Yorker exponía recientemente algunos casos:

Big Brother Watch descubrió que el sistema utilizado por la policía del metro de Londres tenía una tasa de falsos positivos que rondaba el noventa y ocho por ciento, y que la policía guardó en sus archivos imágenes de miles de ciudadanos inocentes por si los necesitaba en futuras búsquedas.

La asociación americana por los derechos civiles ACLU probó el sistema Rekognition, propiedad de Amazon, utilizado por diversas policías norteamericanas, y halló que cometía un número de errores alarmante. Tras analizar las fotografías de los 535 miembros del Congreso, a 28 los confundió con delincuentes. La tasa de error entre los congresistas de raza negra llegó al 40%. Entre los miembros de raza blanca el error fue del 5%.

Un desarrollador del sistema de reconocimiento facial de la policía de Nueva York reconoció que había retocado imágenes mediante programas tipo Photoshop para reemplazar los ojos cerrados de los sospechosos por ojos abiertos de otras personas. “Los ojos son muy importantes para la identificación de un rostro, y ahí estaban usando los de otra persona. Es como tomar la mitad de una huella y dibujar el resto”.

Reconocimiento sesgado

Otro efecto indeseado es el sesgo de los algoritmos con los que se programan las aplicaciones.

Joy Buolamwini es una investigadora norteamericana de origen ghanés, impulsora de la Liga por un Algoritmo Justo y del manifiesto Safe Face Edge. Durante su estancia en el MIT desarrolló el proyecto Gender Shades en el que demostró que las mujeres de piel oscura son mucho más propensas a ser identificadas erróneamente por los sistemas de análisis facial que los hombres de piel clara.

Los tecnólogos creen que los sistemas pueden ser perfeccionados, que tanto los errores como el sesgo algorítmico se pueden corregir y que, por lo tanto, los problemas actuales no invalidan la utilidad de la tecnología de reconocimiento facial.

¿Quién es el responsable?

Los problemas de fondo son otros. En primer lugar, la falta de transparencia y “auditabilidad” de las aplicaciones, un problema que afecta a otras muchas áreas de la tecnología digital y muy especialmente a los algoritmos utilizados por la inteligencia artificial.

En segundo lugar, el modelo de negocio que lo sustenta, inspirado por la lógica de aceleración y disrupción propia de Silicon Valley.

El informe del Ainow Institute denuncia “las pruebas sin control de sistemas de inteligencia artificial en poblaciones humanas: Silicon Valley es conocido por su mentalidad de “moverse rápido y romperlo todo”, mediante la cual se presiona a las empresas para que experimenten con las nuevas tecnologías de forma rápida y sin mucha consideración por el impacto de los errores. En el último año, hemos observado un creciente número de experimentos que implementan sistemas de inteligencia artificial ‘salvaje’, sin protocolos adecuados para la notificación, consentimiento, o la rendición de cuentas. Tales experimentos prosiguen, en parte, por la falta de consecuencias de los fallos. Cuando se producen daños, no está claro ni dónde ni en quién recae la responsabilidad”.

Como combinación de todos estos efectos surge un tercer problema de fondo. La sociedad no ha tenido ni la información ni el debate necesarios para decidir si acepta los sistema generalizados de vigilancia y monitorización ciudadana que limiten otros derechos como el de la privacidad. En China, el país donde más rápidamente se está implantado el reconocimiento facial de los ciudadanos, por supuesto que no los han tenido. Pero en las democracias occidentales, el nivel de desarrollo e implantación acelerado de la tecnología desborda la capacidad de conocimiento de la ciudadanía y las garantías y previsiones de la legislación.

Las advertencias se generalizan

El Ainow Institute resume así los peligros:

-La falta de rendición de cuentas en inteligencia artificial que favorece a los que crean e implementan estas tecnologías a expensas de los afectados.

-El uso de inteligencia artificial para ampliar la vigilancia, especialmente en combinación con el reconocimiento facial, lo que aumenta el potencial para el control centralizado y la opresión.

-El uso creciente de los sistemas automatizados de toma de decisiones que afectan directamente a los individuos y a las comunidades sin mecanismos establecidos de control.

-La experimentación no regulada y sin control sobre la población.

-La vulneración de los límites en los problemas de equidad, los prejuicios y la discriminación.

Un compromiso ético al que las grandes empresas se resisten

Safe Face Edge, por su parte, propone que las empresas suscriban cuatro compromisos:

-Preservar los derechos, valores y dignidad de la vida humana.

-Corregir los sesgos.

-Facilitar la transparencia.

-Implantar el compromiso en todas las prácticas comerciales

Asegura Bloomberg que ninguno de los grandes fabricantes de software como Microsoft, Google, Amazon, Facebook o IBM ha firmado el compromiso de Safe Face Edge.

“Las grandes empresas de tecnología se muestran renuentes a comprometerse a una promesa como ésta, a pesar de que les preocupen las consecuencias negativas de la aplicación de software. Podría alejarlos de lucrativos contratos para desarrollo de tecnología emergente. Según IHS Markit, el mercado de equipos de videovigilancia tiene un valor de 18.5 mil millones dólares anuales, y el análisis ‘inteligente’ de video tiene un gran potencial”, dice Bloomberg.

Amazon ya ha manifestado que “es demasiado pronto para una regulación estricta dado que esta tecnología se encuentra en las primeras etapas de implementación y no hemos recibido indicaciones de uso indebido”.

Así están las cosas, moviéndose rápido y rompiéndolo todo.

Collateral Bits