La creación sintética y la detección de imágenes avanzan aceleradamente mientras la ética va a la baja según el Artificial Intelligence Index Report 2021

.

La abrumadora cantidad de material que se publica sobre los avances de la Inteligencia Artificial dificulta tener una visión clara de hacia dónde se encamina realmente esta tecnología. Tantos árboles creciendo sin parar dificultan la visión del bosque.

Por eso se agradecen informes como el Artificial Intelligence Index Report del prestigioso HAI Center de la Universidad de Stanford que analiza la evolución de la Inteligencia Artificial en el mundo y permite hacerse una idea de las principales tendencias en la investigación y sus efectos en la industria y la economía.

El informe 2021, publicado a primeros de marzo, confirma cosas que ya sabemos o intuimos. La IA se expande en todos los sectores, crece el número de empresas que lo incorporan a sus procesos de gestión y producción (AI Everywhere), aumenta la inversión privada, la competencia entre EEUU y la China se vuelve más cruda, aumenta la oferta de formación y la demanda de especialistas y el ámbito de la salud concentra las mayores inversiones.

Pero ¿hacia dónde va la inteligencia artificial, cuáles son sus tendencias de fondo? ¿En qué avanza la investigación, dónde invierte el capital? El informe da algunas claves.

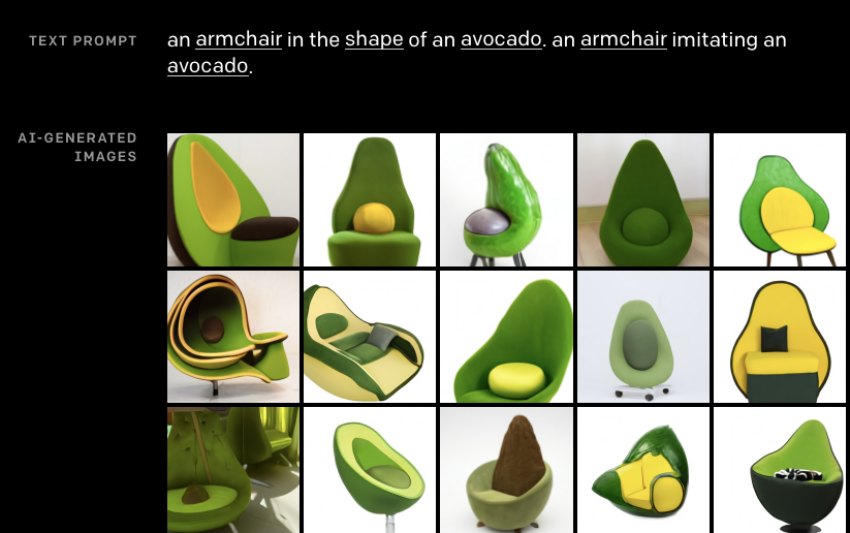

Destaca, por ejemplo, la precisión que están alcanzando las tecnologías dedicadas al Generative Everything, esto es, sistemas que pueden componer texto, audio e imágenes con un estándar lo suficientemente alto como para que los humanos tengamos dificultades para diferenciar lo que está generado por máquinas de lo creado por personas. Una tendencia que promete generar una enorme gama de aplicaciones útiles, menos útiles o incluso peligrosas.

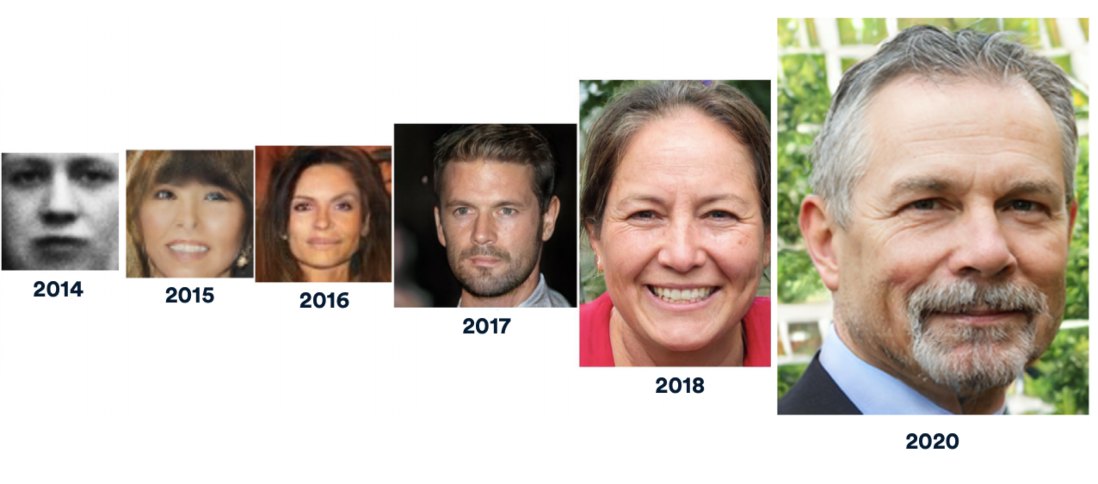

En la imagen de la cabecera reproducimos una muestra de las mejores imágenes sintéticas de rostros humanos creadas en los últimos años. En 2018, su calidad ya superaba la capacidad humana de detectarlas.

.

Una tecnología y su contraria

En paralelo, la propia evolución de la creación sintética ha ido acompañada del desarrollo de tecnologías que tratan de detectarla. La misma industria que lo genera todo trata de limitar el riesgo que entraña aumentar la capacidad para falsear el mundo real mediante fake news, deepfakes, chat bots y creaciones virtuales indistinguibles por el ojo humano… Se desarrolla una industria y automáticamente avanza la contraria. Se fabrica la enfermedad y a la par, el antídoto; los virus y los antivirus…

Pero no sólo de imágenes vive la generación sintética. El rápido progreso en tecnologías de Procesamiento del Lenguaje Natural (PNL) que crean textos y voces artificiales han alcanzado capacidades lingüísticas y matices humanos que se implantan en todo tipo de servicios.

Google y Microsoft han implementado el modelo de lenguaje BERT en sus motores de búsqueda, OpenAI ha desarrollado un modelo de procesamiento de lenguaje de gran tamaño, el famoso GPT3, capaz de redactar por sí solo todo tipo de textos de una calidad estimable, o el reciente DALL E, que genera imágenes a partir de texto.

…

.

El progreso va tan rápido que los avances técnicos han comenzado a superar los medios para evaluar su nivel de calidad. Los últimos resultados de SuperGLUE, una suite de programas informáticos de comprobación de calidad, fueron sorprendentes: según sus indicadores, el lenguaje artificial de Microsoft ya es más rico y preciso que el propio lenguaje humano al que trata de emular. Curioso.

Hacia una vigilancia más precisa, rápida, barata y ubicua

La IA avanza para generarlo todo pero también para identificarlo todo.

La visión por ordenador iniciada en la década de 1960 ha experimentado importantes progresos y en los últimos años ha alcanzado niveles de rendimiento similares a los humanos en algunas tareas. La maduración de la visión por ordenador ha permitido desarrollar una amplia gama de aplicaciones: vehículos autónomos, análisis de imágenes médicas, apps como Google Fotos, aplicaciones industriales como la detección de defectos en la fabricación y montaje de piezas…

Gracias a los avances en este campo, los sistemas de vigilancia se sofistican rápidamente con la incorporación de técnicas de clasificación de imágenes, reconocimiento facial, análisis de video e identificación de voz. Todas experimentaron progresos significativos en 2020 y cada vez son más precisas, rápidas, baratas y ubicuas.

El siguiente gráfico muestra las curvas de reducción de errores en las identificaciones mediante reconocimiento facial automático según pruebas realizadas por el Instituto Nacional de Estándares y Tecnología (NIST) de Estados Unidos. En 4 años, la tasa de error en las tecnologías de reconocimiento usadas en el ámbito policial ha caído de casi el 50 por ciento a porcentajes por debajo del 1 por ciento.

Ya se adivina que, cuando se depure la calidad de los datos de los que parte, el problema ético de la inteligencia artificial aplicada a la vigilancia no vendrá tanto de los sesgos algorítmicos que discriminan a la población sino de la precisión y el bajo coste que les permitirá desplegarse acelerada e inadvertidamente.

.

A la ética le falta concretar

El informe dedica un capítulo al estado de la ética de la IA. Ahí las conclusiones no son optimistas. A pesar de que constata el incremento de publicaciones y organismos preocupados por el tema, parece que en el mundo empresarial la ética no cuaja.

El informe se hace eco de una encuesta de Mackinsey publicada en noviembre pasado en la que constataba que los esfuerzos de la industria por atender las preocupaciones éticas de la sociedad siguen siendo escasos. Cuestiones como la equidad y la justicia en la IA siguen recibiendo comparativamente poca atención por parte de las empresas, concluye el informe. Además, en 2020, el porcentaje de empresas que consideraban relevantes los riesgos sobre la privacidad de las personas era inferior al de 2019. No hubo cambios en el porcentaje de empresas que adoptan medidas para mitigar estos riesgos.

HAI reclama que la comunidad científica haga un esfuerzo para cuantificar o elaborar indicadores éticos. Se ha conseguido que los políticos sean conscientes de las consecuencias éticas de la IA, dice el informe, “pero es más fácil que administren lo que pueden medir, por lo que encontrar formas de traducir los argumentos cualitativos en indicadores cuantitativos será un paso esencial en el proceso”, dice el informe.

Conclusión: La Inteligencia Artificial avanza para generarlo todo e identificarlo todo en un ambiente social de preocupación ética que no acaba de concretar su respuesta al desafío.

2 comments

Joan,

Muchas gracias una vez más por la referencia y la reflexión.

Con todo, creo que la conclusión de tu artículo podría haberse redactado de otro modo. Si de verdad hubiera “un ambiente social de preocupación ética” acerca de la evolución de la IA, ésta no avanzaría al ritmo que lo está haciendo. Que de otra parte no es casual, sino una consecuencia directa de los intereses (y la despreocupación ética) de quienes impulsan ese avance. Me temo pues que hay un estado de preocupación social acerca de la AI, sino tres: la indiferencia o desconocimiento de muchos,la despreocupación por la ética de otros y (de momento) por la impotencia de otros (entre los que me incluyo y te imagino incluido) para concretar respuestas.

Muy cordialmente

^

Es una guerra tecnologica, y lo etico es aprender a defenderse.

El ultimo grafico reproducido aqui demuestra de forma clara la prioridad de las empresas. Los primeros tres puntos — seguridad, cumplimientio normativo, y explicabilidad — es lo que aqui se llama una ‘politica CYA’ (‘cover your ass.’) Es decir, a la empresa le preocupa poder defenderse de posibles ataques de terceros (seguridad) y del gobierno (normativa), con la explicabilidad como herramienta en el ultimo caso. En realidad, a la empresa lo que realmente le importa es sacar provecho; es solo que sin los tres puntos mencionados, su fuente de riqueza peligra. Todo lo demas es secundario y prescindible. Si hacen algo al respecto, es, una vez mas, porque no hacerlo tiene mayor coste que hacerlo.

A los ‘ingenieros’ informaticos y demas personas involucradas en este tipo de proyectos en la empresa tampoco les preocupa la etica. Cosa que no es de extranyar, ya que no se suele ensenyar en grados de informatica, y si lo es, suele quedar relegada al puesto de optativa o algo similar.

Yo he trabajado en estas corporaciones, y puedo corroborar lo hasta ahora mencionado en base a mi propia experiencia.

Como ha dicho Ruiz de Querol, la situacion actual es causal, no casual. Hasta ahora, a mi me ha sido muy util preguntarme quien genera la inversion para entender el por que de la misma. En el caso de China, es bastante facil de entender. En el caso de USA, es el desarrollo de lo que se conoce como ‘surveillance capitalism’, y algun que otro proyecto militar. En un caso tenemos un control absoluto por parte del gobierno, en el otro por parte de las corporaciones. Ninguno de los dos resultados es etico ni avantajoso para el pueblo.

Asi que lo etico, llegados a este punto, es empezar a defendernos. El EFF aqui ha pasado varios moratorios que prohiben el uso de la identificacion facial por parte de la policia en varias ciudades. Como minimo, eso da un poco mas de tiempo a pensar. En ultima instancia, debemos pasar leyes para prohibir y controlar el uso de la tecnologia y mantener al gobierno y a las corporaciones firmes, o si no, nos van a mantener firmes ellos a nosotros.