Sesenta entidades internacionales piden que la Comisión Europea prohíba la vigilancia biométrica masiva en espacios públicos y los sistemas automatizados de policía predictiva

.

La Comisión Europea presentará este trimestre una propuesta legislativa de promoción y regulación de la inteligencia artificial. Es un texto clave que definirá la estrategia europea en un tema fundamental para el desarrollo económico y social de las próximas décadas y en el que hoy Europa juega un papel secundario.

El marco en el que la Comisión Europea se quiere mover ya quedó definido en el libro blanco sobre inteligencia artificial que presentó en febrero. Ahora toca concretar políticas, definir prioridades y fijar límites. Como es habitual, los lobbies están trabajando para influir en el texto.

La parte empresarial quiere evitar un exceso de celo regulador que limite la expansión de esta tecnología y perpetúe la inferioridad europea ante los polos chino y norteamericano que avanzan con más fuerza y menos escrúpulos. Algunos lobbies critican la experiencia del Reglamento Europeo de Protección de Datos, demasiado estricto según su criterio, y lo consideran un descuido en su labor de influencia que ahora no se pueden permitir.

Por su parte, las organizaciones sociales tratan de impedir que, a rebufo del impulso chino-norteamericano y en aras del progreso económico, se consolide un modelo de inteligencia artificial poco respetuoso con los derechos y valores de la sociedad europea.

Quince países europeos experimentan la vigilancia biométrica

Unas sesenta organizaciones internacionales que velan por la defensa de los derechos humanos en el ámbito digital han enviado una carta abierta a la Comisión Europea en la que exigen que la nueva legislación defina claramente las líneas rojas que la Inteligencia Artificial no debe traspasar. Son entidades de prestigio, algunas de ellas encuadradas dentro de la asociación European Digital Rights (EDRI) y otras como Amnistía Internacional, Algorithm Watch, Ai Now Institute o Human Rights Watch.

¿Qué piden estas entidades?

En términos generales,“límites regulatorios en las implementaciones de inteligencia artificial que afecten indebidamente a los derechos humanos”.

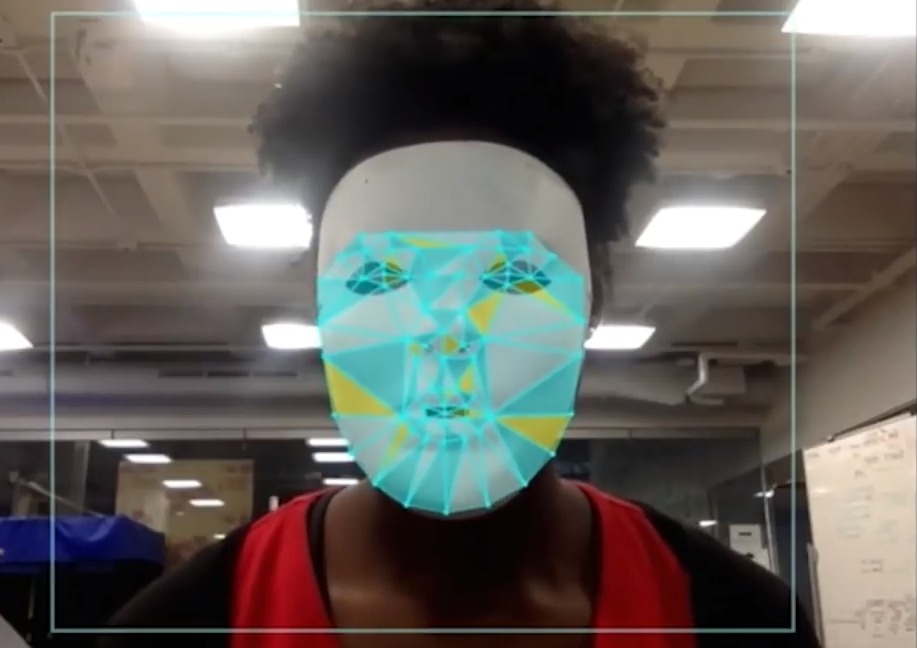

En términos más concretos, la carta pide directamente algunas prohibiciones. La primera, la vigilancia biométrica en espacios públicos. Es decir, el uso de tecnologías como el reconocimiento facial o corporal en las calles, estadios, conciertos… “La vigilancia biométrica masiva invade la integridad psicológica y el bienestar de las personas, además de violar una amplia gama de derechos fundamentales”, denuncia la carta.

.

La vigilancia biométrica es una práctica creciente en regímenes no democráticos como China, pero ¿lo es también en Europa? ¿Existe realmente el peligro de que se nos identifique en la calle y se vigilen nuestros movimientos?

En un documento anterior, EDRI denunció que hasta mayo del 2020 al menos 15 países “habían experimentado sistemas de este tipo, sin transparencia, ni rendición de cuentas y sin la debida proporcionalidad, evaluaciones, advertencia pública adecuada o debate social”.

Las asociaciones firmantes creen imprescindible que se prohíba explícitamente el uso de esta tecnología para garantizar “que las fuerzas del orden, las autoridades nacionales y el sector privado no puedan abusar del uso discrecional que les permiten los principios legales existentes”.

Prohibición o moratoria para la IA en el control de fronteras

Las entidades también piden que se prohiban los sistemas de vigilancia predictiva con los que, a partir de determinados datos, se deduce el nivel de riesgo delictivo de una persona. Piden su prohibición porque “socavan la presunción de inocencia entre otros derechos y tratan a las personas como individualmente sospechosas según su adscripción a determinados grupos sociales, raza u origen”.

Son flagrantes los abusos cometidos en Estados Unidos, país en el que esta tecnología está ampliamente implantada ( y denunciada), mediante la cual afroamericanos, pobres e inmigrantes son sistemáticamente identificados como población de riesgo.

.

También los controles fronterizos incorporan sistemas de vigilancia provistos de inteligencia artificial. Además de reconocimiento facial, se usan, por ejemplo, como detectores de mentiras que ‘verifican’ las solicitudes de inmigración o en la identificación de engaños en las pruebas de conocimiento suficiente de idiomas mediante técnicas de análisis de voz que carecen de base científica.

Los firmantes piden que se prohíban estas tecnologías automatizadas o que se implante una moratoria hasta que sean evaluados de forma independiente para asegurar que se respetan los derechos humanos internacionales.

Restringir los sistemas de puntuación social

No se pide prohibir pero sí restringir el uso de sistemas de puntuación social que dan acceso a determinados derechos y beneficios sociales.

Flagrantes errores detectados en sistemas de asignación automática de ayudas y beneficios sociales demuestran el riesgo que comportan.

Uno de los escándalos más sonados conocido a principios del 2020 lo protagonizó SyRI, un sistema de elaboración de perfiles de riesgo que utilizaba el gobierno holandés. Este sistema vinculaba y analizaba grandes cantidades de datos personales como la identidad, lugar de trabajo, bienes muebles e inmuebles, nivel de educación, pensiones, negocios, ingresos y activos, pensiones y deudas… El objetivo era prevenir y combatir el abuso en la obtención de ayudas de la seguridad social, el fraude fiscal y el incumplimiento de la legislación laboral.

Con todos esos datos SyRI elaboraba perfiles de ciudadanos con mayor riesgo de fraude. De pronto, todos los habitantes de los Países Bajos, sobre todo los inmigrantes, se convirtieron en sospechosos.

En febrero de 2020, un tribunal de la Haya dictaminó que Syri suponía una invasión desproporcionada en la vida privada de los ciudadanos y el gobierno holandés clausuró el sistema.

Sistemas automáticos de puntuación y clasificación de desempleados se han denunciado también en Polonia, y en el ámbito educativo se empiezan a implantar sistemas automatizados de monitorización de estudiantes.

Por último, las organizaciones sociales piden restringir también el uso de instrumentos de evaluación de riesgos en el sistema judicial. “Pruebas sustanciales demuestran que la introducción de estos sistemas en la justicia penal ha dado lugar a resultados injustos y discriminatorios y, además, a los profesionales del derecho les puede resultar imposible comprender el razonamiento existente detrás de los resultados de un sistema automatizado”.

Objetivo: impedir la manipulación y el control del comportamiento y las amenazas a la dignidad humana, la autonomía personal y la democracia colectiva

En definitiva, las asociaciones piden que se prohíba o restrinja la aplicación de procedimientos automáticos basados en inteligencia artificial cuando faciliten:

– la vigilancia y el seguimiento biométrico masivo en espacios públicos.

– la discriminación y exclusión de determinados colectivos.

– la restricción y el acceso discriminatorio a servicios esenciales como la atención médica y la seguridad social.

– la vigilancia de los trabajadores y la vulneración de sus derechos laborales.

– el impedimento a un acceso equitativo a la justicia.

– La inferencia o predicción de nuestros comportamientos y pensamientos.

En definitiva, que se impida la manipulación y el control del comportamiento y las amenazas a la dignidad humana, la autonomía personal y la democracia colectiva.