Implementar una ciencia de datos ética es tan importante como asegurarse de que un automóvil autónomo sepa cuándo frenar

Cuando usas un sistema de aprendizaje automático, no solo estás optimizando modelos y agilizando el negocio. Estás gobernando. De hecho, esos sistemas incorporan reglas que controlan el acceso de muchas personas a oportunidades y recursos. Orientan decisiones sobre a quién investigar, encarcelar, prescribir una medicación, o conceder un préstamo, una póliza de seguros, una vivienda o un trabajo.

Por la misma razón que el aprendizaje automático es valioso -ayuda a tomar decisiones operativas de manera más eficaz- su poder impacta en la vida de millones de personas. Las amenazas a la justicia social surgen cuando ese impacto es perjudicial, cuando los modelos limitan sistemáticamente las oportunidades de los grupos más desfavorecidos o vulnerables.

A continuación presento seis formas de aprendizaje automático que amenazan la justicia social:

(Los videos que completan cada apartado forman parte del curso Machine Learning for Everyone que el autor imparte en Coursera )

.

1) Modelos descaradamente discriminatorios

Son modelos predictivos que basan sus decisiones, parcial o totalmente, en una clase protegida. Las clases protegidas pueden serlo por razón de raza, religión, origen, género, orientación sexual o grado de discapacidad. Al adoptar alguna de estas características como un input del modelo, los resultados y las decisiones que se obtienen se basan, al menos en parte, en la pertenencia a esa clase protegida. Rara vez los modelos lo muestran explícitamente, pero hay indicios de que sí lo hacen.

Un modelo podría, por ejemplo, discriminar explícitamente a unos acusados por el hecho de ser negros. Imagínese que usted tiene que evaluar a una persona que desea obtener un trabajo, un préstamo o incluso la libertad condicional. Cuando esa persona le pregunta cómo funciona el proceso de decisión, usted le dice: “Nuestro algoritmo le ha quitado siete puntos por ser usted negro“. Puede sonar impactante y sensacionalista, pero solo estoy describiendo lo que mecánicamente haría el modelo si la raza se aceptara como un input válido.

Modelos discriminatorios. Video 1

Precedentes y tendencias de los modelos discriminatorios. Video 2

Por qué hay que impedir los modelos discriminatorios. Video 3

.

2) Sesgo de la máquina

Cuando las clases protegidas no se utilizan como un input directo también se dan casos en los que las predicciones del modelo siguen siendo poco equitativas. Esto se debe a que hay otras variables indirectas que acaban representando a las clases protegidas. No es fácil distinguirlas porque los modelos que son equitativos en un sentido no lo son en otro.

Por ejemplo, algunos modelos que evalúan el riesgo de que una persona cometa un delito logran señalar con la misma precisión a acusados blancos y negros, independientemente de la raza. Sin embargo, acaban señalando erróneamente a los acusados negros con más frecuencia que a los blancos.

Un modelo de análisis de riesgo delictivo llamado COMPAS que utilizan policías de todo EE. UU. tiene una tasa de error del 23,5 % en acusados blancos y un 44,9% en acusados negros. En otras palabras, a las personas de raza negra acusadas injustamente se las señala casi el doble de veces que a los acusados de raza blanca.

El enigma de los modelos poco equitativos. Video 1

Por qué se generan esos modelos. Video 2

La justicia no puede ser daltónica. Video 3

.

3) Inferencia de atributos sensibles

El aprendizaje automático predice información sensible de las personas, como la orientación sexual, si están embarazadas, si dejarán su trabajo o si van a morir. Investigadores han demostrado que es posible predecir la raza de una persona basándose en sus likes en Facebook. Estos modelos predictivos son muy peligrosos.

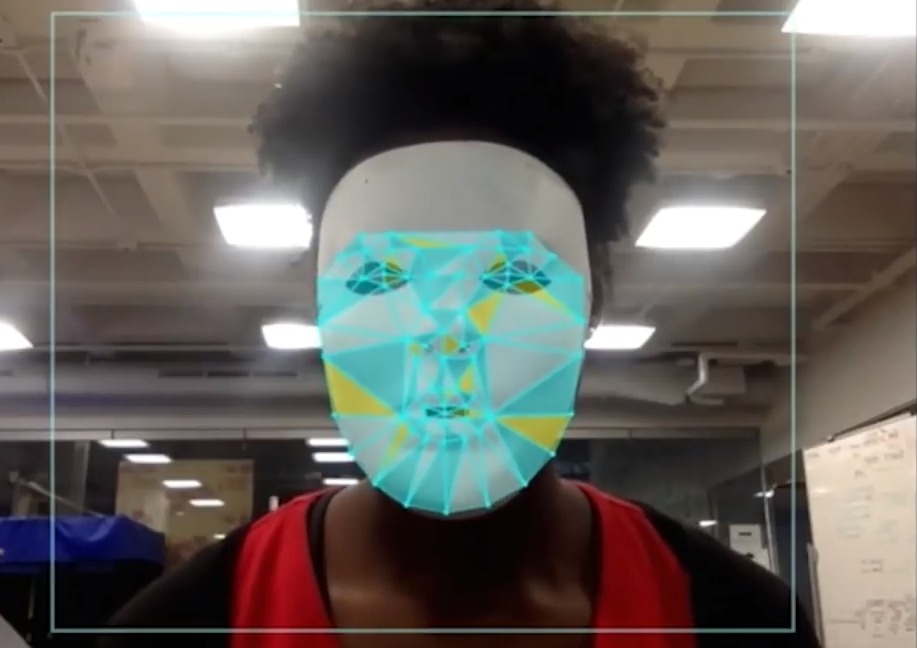

Un caso particularmente extraordinario es el de los funcionarios chinos que utilizan reconocimiento facial para identificar y rastrear a los uigures, un grupo étnico minoritario sistemáticamente oprimido por el gobierno. Este es el primer caso conocido de un gobierno que utiliza el aprendizaje automático para crear perfiles por etnia. Una nueva empresa china valorada en más de mil millones de dólares dijo que su software podría reconocer a “grupos de personas sensibles”. Su web anunciaba: “Si en un plazo de 20 días un uigur recibe la visita de seis uigures, el sistema envía inmediatamente una alarma” a la policía.

Inferencias sensibles. Video

.

4) Falta de transparencia

Un ordenador puede hacer que sigas en la cárcel o negarte un trabajo, un crédito, una póliza de seguros o una vivienda, y sin embargo, no puedes enfrentarte a él. Generalmente, los modelos predictivos creados mediante aprendizaje automático que abordan decisiones importantes se mantienen en secreto, no disponibles para una auditoría o una inspección. Al ser inaccesibles se hace muy difícil el seguimiento del proceso y la rendición de cuentas.

Dos estándares éticos se enfrentan a esta opacidad de las decisiones asistidas electrónicamente: 1) transparencia, para que los modelos predictivos sean accesibles, inspeccionables y comprensibles. Y 2) el derecho a la explicación, para que las decisiones producidas o informadas por un modelo predictivo se atengan siempre al estándar de transparencia.

Cumplir con esos estándares supone, por ejemplo, que se le diga a un acusado qué factores han contribuido a su calificación de riesgo delictivo, qué aspectos de sus antecedentes, circunstancias o comportamiento pasado han causado la penalización del acusado. Esto les daría la oportunidad de responder en consecuencia, situar el contexto y dar explicaciones.

Explicabilidad en aprendizaje automático. Video

.

5) La depredación del micro-targeting

La impotencia engendra impotencia, y para los consumidores este ciclo puede aumentar cuando el aprendizaje automático incrementa la eficiencia de las actividades diseñadas para maximizar los beneficios de las empresas. Las mejoras en micro-targeting y en predicción de precios de seguros y créditos pueden afectar el nivel de pobreza de las personas. Los anuncios hiper personalizados son muy eficientes para explotar a los consumidores más vulnerables.

La regla principal de las compañías de seguros consiste en cobrar más a quienes corren más riesgo. Pero si este proceso no se controla puede derivar rápidamente en la fijación de precios que tienen unos efectos depredadores. Por ejemplo, un modelo que analiza las tasas de abandono de los clientes puede considerar que la gente mayor no acostumbra a comparar precios ni opta por atender las mejores ofertas, por lo que las compañías tienen menos incentivos para bajar los precios de las pólizas a esas personas. Además, las primas basadas en otros factores de la vida del asegurado también contribuyen a incrementar su nivel de pobreza. Por ejemplo, a las personas que tienen calificaciones crediticias bajas se les cobra más por el seguro de automóvil. De hecho, una puntuación de crédito baja puede aumentar la prima más que un accidente responsabilidad del titular.

Micro-targeting depredador. Video

.

6) La mirada codificada

Si un grupo de personas está subrepresentado en los datos de los que aprende la máquina, el modelo resultante no funcionará bien para los miembros de ese grupo. Esto conduce a situaciones de exclusión y prácticas discriminatorias que se pueden dar tanto en el análisis de imágenes faciales como en el reconocimiento de voz.

Luchando contra el sesgo de los algoritmos ( Joy Buolamwini) Video

.

La ética como una vía de activismo social

Solución: adoptar estándares éticos de aprendizaje automático como una forma de activismo social.

Para abordar estos problemas, es preciso adoptar la estandarización ética del aprendizaje automático como una forma de activismo social. Debemos aplicar estándares que vayan más allá de tópicos que suenan bien pero que son demasiado vagos, como “ser justo“, “evitar prejuicios” y “garantizar la responsabilidad“. Sin una definición precisa, estas frases son subjetivas y sirven de poco para orientar acciones concretas. Desafortunadamente, este lenguaje tan genérico es bastante común entre los principios publicados por muchas empresas que protegen más su imagen que al público.

El rol de los directivos es fundamental. Si eres uno de ellos y estás involucrado en la implementación de aprendizaje automático, dispones de una voz poderosa e influyente, posiblemente mucho más importante de lo que crees. Eres uno entre un número relativamente pequeño de personas que moldean y marcan la trayectoria de los sistemas que determinan automáticamente los derechos y recursos a los que tienen acceso un gran número de consumidores y ciudadanos. Estás en una posición única para defender los derechos civiles de cientos de miles o millones de personas y, por lo tanto, tienes la responsabilidad de hacerlo.

El prestigioso educador y experto en aprendizaje automático Andrew Ng dijo: “La inteligencia artificial es un superpoder que permite que un equipo pequeño influya en la vida de una gran cantidad de personas… Es importante que usted… se asegure de que su trabajo deje la sociedad en una situación mejor“.

Y Allan Sammy, director de ciencia de datos y análisis de auditoría de Canada Post, aclaró por qué la responsabilidad recae sobre nosotros: “Una decisión tomada por el modelo analítico de una organización es una decisión tomada por el equipo de alta dirección de esa entidad”.

Implementar una ciencia de datos ética es tan importante como asegurarse de que un automóvil autónomo sepa cuándo detenerse.

Establecer estándares éticos bien formados para el aprendizaje automático será un proceso intenso y contínuo.

(Para obtener más información, mira este breve video en el que proporciono algunos detalles sobre cómo poner en marcha el proceso.)